AI udělala další krok vpřed. Výzkumníci z Applu ve spolupráci s Renmin University of China představili nový model umělé inteligence s názvem VSSFlow, který řeší dlouhodobý problém generování zvuku z tichého videa. Dosavadní přístupy se obvykle dělily na dvě oddělené oblasti. Modely zaměřené na zvukové efekty si neuměly poradit s řečí a text-to-speech systémy naopak selhávaly u zvuků (mimo zvuk řeči). VSSFlow jde jinou cestou a kombinuje obě schopnosti do jednoho jednotného systému.

Mohlo by vás zajímat

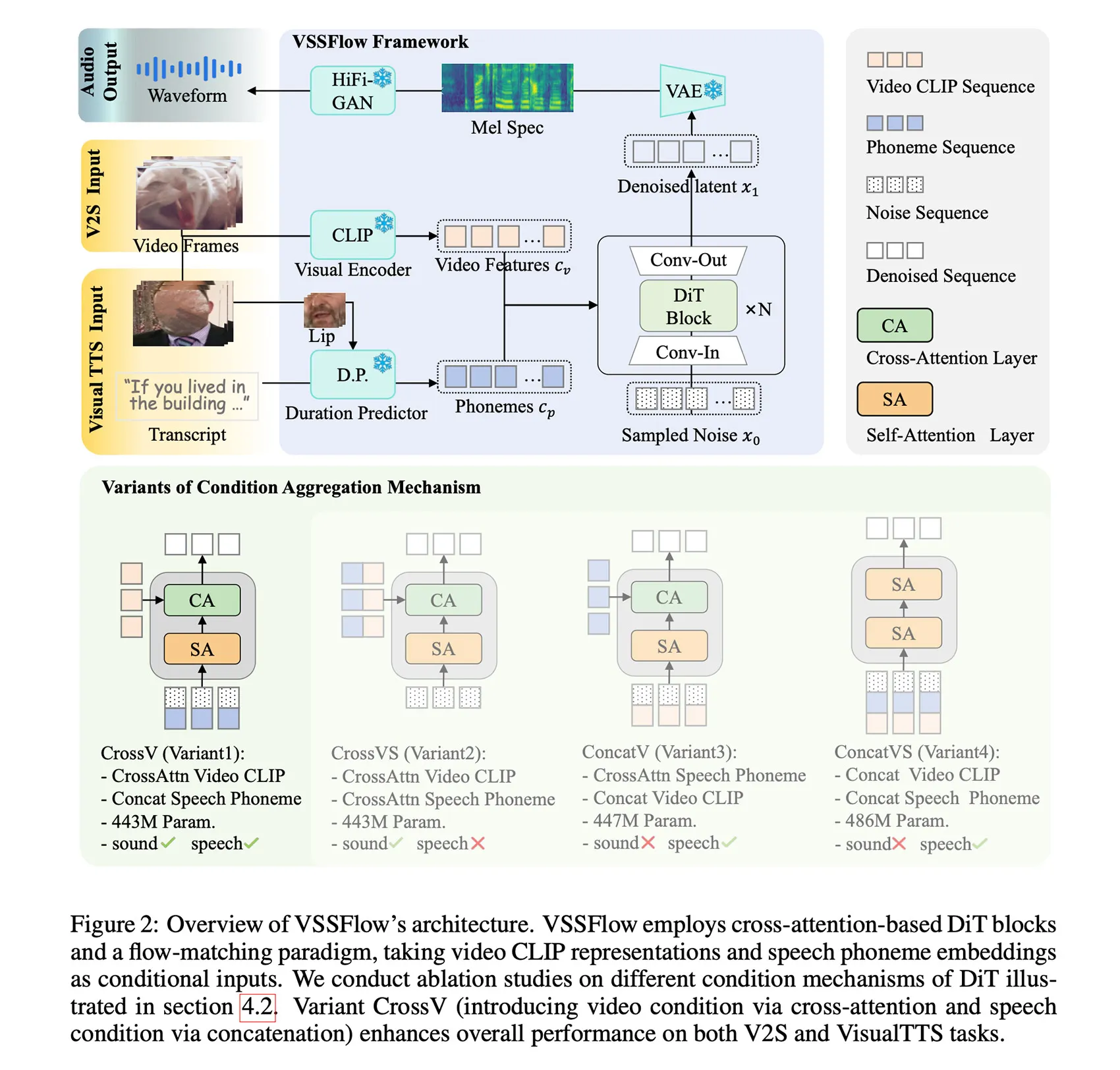

Zásadní novinkou je architektura, která neodděluje trénink řeči a zvuku do samostatných fází. Naopak ukazuje, že společné učení obou oblastí vede ke zlepšení výsledků na obou stranách. Podle autorů se tak vyvrací předpoklad, že by společný trénink nutně snižoval kvalitu výstupů.

Zcela nový přístup

Model pracuje s kombinací vizuálních informací z videa a textového přepisu řeči. Přepis je převeden na sekvence a celý systém je trénován pomocí techniky flow-matching, která model učí rekonstruovat výsledný zvuk postupně z náhodného šumu. Vše je integrováno do desetivrstvé architektury, jež přímo propojuje video i text s generováním audia.

Při tréninku výzkumníci využili směs tří typů dat. Tichá videa s okolními zvuky, videa mluvících osob s přepisy a klasická text-to-speech data. Aby model dokázal generovat řeč a zvukové efekty současně, byl následně doladěn na syntetických ukázkách, kde jsou oba typy audia smíchány dohromady.

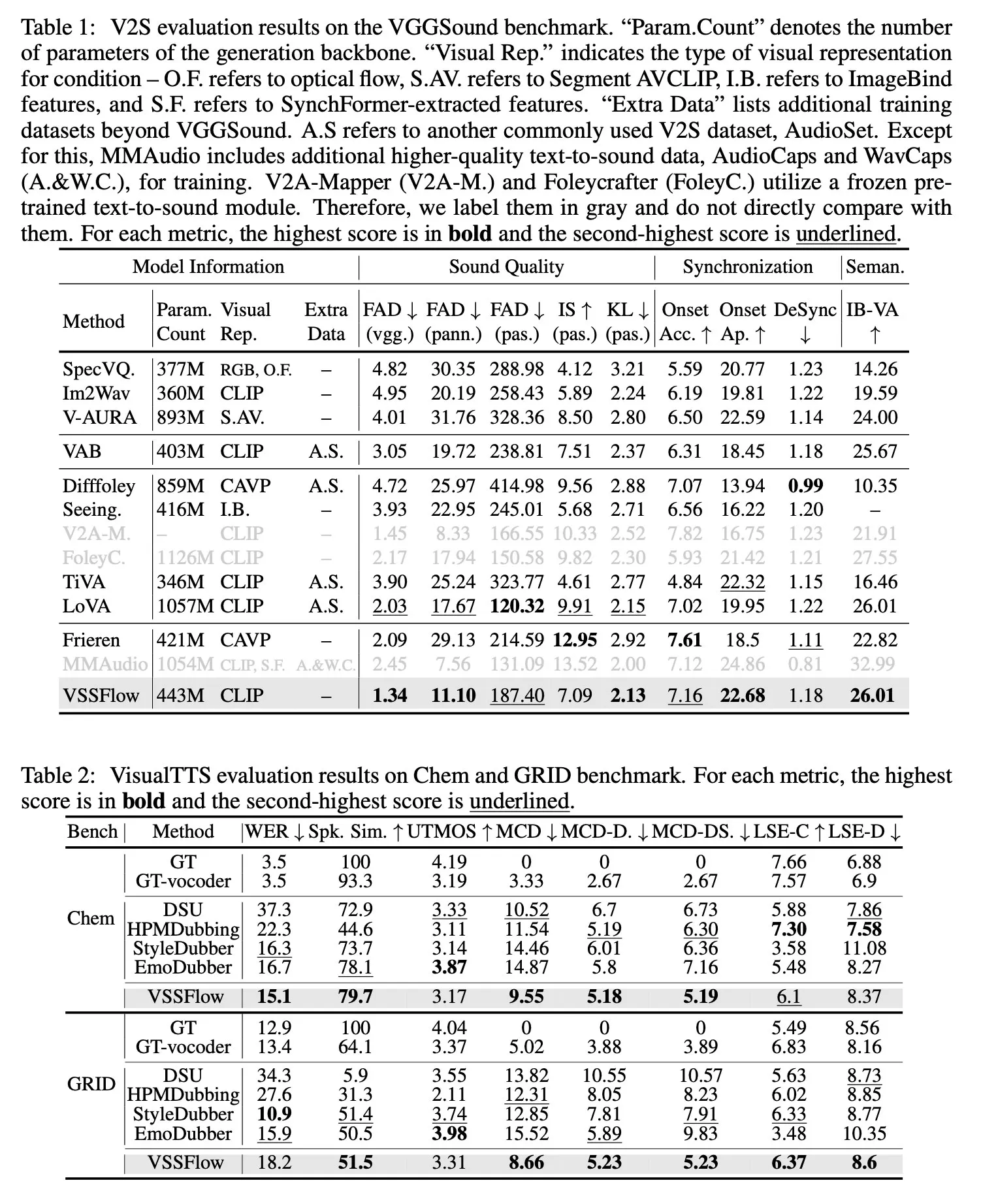

V praktických testech VSSFlow dosáhl konkurenceschopných výsledků vůči specializovaným modelům, přestože jde o jediný sjednocený systém. Výzkumníci navíc zveřejnili zdrojový kód na GitHubu. Jde tedy o další krok, díky němuž budou videa působit o něco přirozeněji. Už nyní musím kolikrát zhlédnout video na Reels vícekrát, abych si dokázal správně vyhodnotit, zda jde o výtvor AI či nikoli. Pokud bude výzkum pokračovat, zřejmě bude rozpoznání ještě těžší.