Skupina studentů z kalifornské univerzity v Berkeley ukázala, že v na první pohled (respektive poslech) neškodných hudebních nahrávkách se klidně mohou ukrývat škodlivé a zlomyslné příkazy pro virtuální asistenty, jimiž jsou Siri, Google Assistant a Alexa. Útočníci by mohli převzít kontrolu nad inteligentní domácností, a to pouze tím, že byste si přehráli konkrétní skladbu s příkazy přes rádio či streamovací platformu.

Server NY Times uvádí, že vychází z výzkumu, který odstartoval v roce 2016. „Během posledních dvou let vědci v Číně a ve Spojených státech začali ukazovat, že mohou odeslat skryté příkazy, které jsou pro lidské ucho neslyšitelné, virtuálním asistentům, jako jsou Siri, Alexa a Google Assistant. V univerzitních laboratořích dokázali vědci potají aktivovat systémy umělé inteligence na smartphonech a inteligentních reproduktorech, a tak například dokázali bez problémů vytočit nějaké telefonní číslo anebo otevřít konkrétní webovou stránku. Pokud by technologii začali využívat špatní lidé, mohla by být použita například k odemčení dveří, zaplacení peněz přes účet či nákupu zboží online, a to pouze přes přehrávání hudby přes rádio.“

Mohlo by vás zajímat

Výzkum z roku 2016 ukázal, že příkazy se skrývají i v bílém šumu. Ovšem studentům z kalifornské univerzity v Berkeley se tento měsíc podařilo udělat totéž v hudbě a mluveném slovu. Pouze nepatrně změnili zvukovou stopu tak, že do ní zakomponovali příkazy, které jsou pro lidské ucho nedetekovatelné, a tak je dokázaly „slyšet“ pouze přístroje. Studenti tak dokázali skrýt do mluveného slova příkaz: „Dobře, Google, spusť stránku evil.com.“ Přičemž záznam, který slyšel člověk, zněl: „Bez datové sady je článek zbytečný.“ Lidé tak nezjistili, že je v mluveném slovu ukrytý nějaký příkaz pro Google Assistant.

Podobné techniky byly prokázány pomocí ultrazvukových frekvencí. Výzkumní pracovníci na pricetonské univerzitě a čínské univerzitě Zhejiang prokázali, že systémy rozpoznávání hlasu by mohly být aktivovány použitím frekvencí, které nejsou slyšet lidským uchem. Útočník by zároveň ztlumil zvuk telefonu či inteligentního reproduktoru, a tak by majitel neslyšel ani reakce systému.

Mohlo by vás zajímat

Vědci z kalifornské univerzity v Berkeley říkají, že sice se prozatím neukázalo, že by útočníci zmíněné nekalé praktiky využívali, nicméně v blízké budoucnosti by se to mohlo klidně změnit.

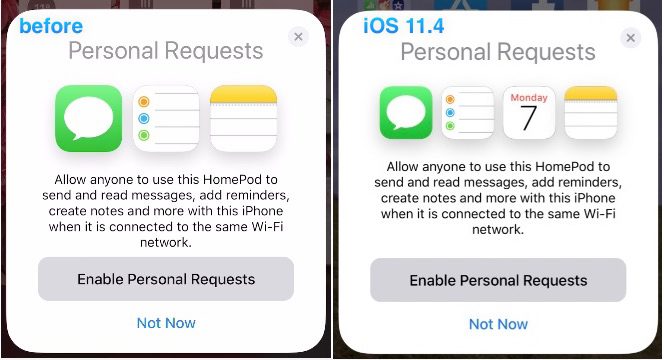

Apple však uvedl, že Siri má bezpečnostní prostředky, které útočníkovi neumožňují provádět některé úkony. Jeho inteligentní reproduktor HomePod je navržen tak, že neprovede příkazy jako odemknutí dveří. Cupertinská společnost navíc poznamenala, že iPhony a iPady musí být nejprve odemčeny, aby mohla Siri provést příkazy, jež přistupují k citlivým datům uživatelů, chtějí otevřít aplikace či webové stránky.