Jablečný framework Vision nabízí vývojářům celou řadu neoddiskutovatelných výhod, bez nichž by se takřka neobešli. Jednou z nich je například i to, že dokáže rozeznávat text, obrázky, obličeje, krajinu a další předměty a objekty, na jejichž bázi lze rozšiřovat a adaptovat AR. Aby toho však nebylo málo, dočká se tento šikovný nástroj v iOS 14 a macOS Big Sur podstatného vylepšení, které tkví zejména v rozeznání gest a tělesných postojů. Většího představení této funkce jsme se dočkali v novém videu těsně po úvodní Keynote, kde Apple nastiňuje možnosti Visionu.

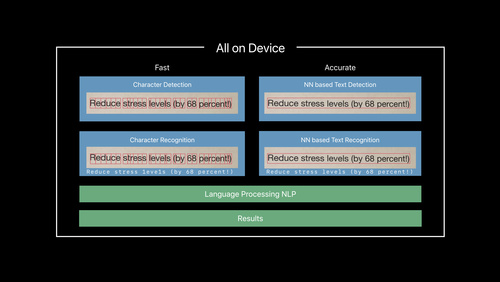

Vývojáři často nedají na Vision framework dopustit a uchylují se k němu při vývoji nejen aplikací založených na detekci reálných objektů, ale i při práci na rozšířené realitě. Dosud byl však nástroj v možnostech stále poměrně omezený a nabízel pouze rozeznání základních a jednoznačných věcí, jako jsou obličeje, text, krajina nebo každodenní předměty. V nové aktualizaci se v iOS 14 a macOS Big Sur ale dočká podstatného rozšíření tohoto seznamu, kam přibudou gesta a postoje těla. Aplikace a software tak budou moci nově rozlišovat gesta uživatelů, adaptovat se na ně a využívat je jako standardní prvek. Nejlepším příkladem jsou pak fitness aplikace, které dokáží efektivně zanalyzovat cviky uživatele a zhodnotit je.

Mohlo by vás zajímat

Podobnou funkci lze ale využít i při hledání a editování fotografií, kdy stačí najít zkrátka fotku zachycující určitý postoj. Ruční gesta by pak otevřela dveře mnoha aplikacím třetích stran, které by spoléhaly na ovládání bez dotyku displeje. Jediný problém podle vývojářů nastává v případě, že lidé nosí rukavice, nebo jsou v případě detekce postoje oblečení do hodně volných oděvů. Rozhodně se ale jedná o krok kupředu, zejména tedy pro ARKit a rozšířenou realitu, kde lze tyto novinky efektivně využít a pomocí strojového učení vytěžit na maximum. S tím má pomoci i nový LiDAR senzor v iPadu Pro a lepší vykreslování virtuální objektů v iPhonu 12.